Questo argomento è stato già discusso con gli autori nella trasmissione di Rai Radio3 Scienza dal titolo “Una difficile congettura,” andata in onda il 26 settembre 2018 che trovate qui

vai alla trasmissione su Radio3 Scienza

vai alla trasmissione su Radio3 Scienza

Di seguito un articolo più dettagliato.

Ipotesi e Congetture

Prima di dedicarci agli argomenti principali, spieghiamo perché preferiamo parlare di Congettura anziché Ipotesi. Quando si enuncia un teorema, per esempio sui triangoli, si comincia elencando le ipotesi: “Sia \(ABC\) un triangolo, rettangolo in \(A\).” Poi si dice qual è la tesi. Dopo tutto questo, segue la dimostrazione, e cioè un misto di calcoli e spiegazioni che devono convincere i lettori (pignoli come sanno essere i matematici), che effettivamente la tesi è una conseguenza dell’ipotesi, attraverso una serie piú o meno lunga di passaggi, con calcoli complessi o meno, spesso lasciati in gran parte alla verifica del lettore volenteroso, per economia di spazio.

Dunque un’ipotesi è una parte essenziale dell’enunciato di un teorema: è vera per una classe di oggetti matematici, può essere falsa per un’altra classe. Per quest’ultima classe la proprietà nella tesi del teorema può essere vera o falsa: molto semplicemente, il teorema non si applica nei casi in cui l’ipotesi non è soddisfatta.

Una congettura, invece, è un problema aperto di cui non si conosce la soluzione, pur essendoci stato qualche serio tentativo di dimostrazione. Chi propone una congettura dovrebbe fornire un’argomentazione in suo sostegno e magari spiegare anche perché sarebbe utile sapere che è vera, cioè quali interessanti conseguenze avrebbe. È proprio per questo motivo che la Congettura di Riemann è piú nota con il nome di Ipotesi: per l’enorme numero di teoremi che sono stati dimostrati supponendone la verità, cioè mettendola tra le ipotesi.

In estrema sintesi: un’ipotesi è qualcosa di vero in alcuni casi, falso in altri. Una Congettura è vera o falsa, ma in questo momento non sappiamo quale delle due! In linea di principio, la Congettura di Riemann potrebbe essere indecidibile, ma ben pochi esperti del campo pensano che sia cosí. Nel caso della Congettura di Riemann, è pensabile che se ne possa dimostrare la falsità esibendo un controesempio per una delle sue numerose formulazioni alternative.

La Congettura di Riemann (RH)

Abbiamo già spiegato nel modo piú semplice possibile cos’è l’Ipotesi di Riemann in una serie di articoli su “MaddMaths!”: [1 ]A. Zaccagnini, Una versione elementare della Congettura di Riemann, MaddMaths!

(2016), [2 ]A. Zaccagnini, C’è veramente un nuovo approccio alla Congettura di Riemann?, MaddMaths! (2017) e [3 ]A. Zaccagnini, Scacco matto all’Ipotesi di Riemann in tre semplici (?) mosse, MaddMaths! (2018). Ricordiamo brevemente la storia: già Carl Friedrich Gauss alla fine del XVIII secolo si era posto una domanda importante sulla distribuzione dei numeri primi ed aveva dato una risposta sulla base dei dati “osservati” per i numeri primi fino a qualche milione. Anche Adrien-Marie Legendre, in forma meno precisa, giunse a conclusioni simili nello stesso periodo.

La domanda giusta sui numeri primi non è “quanto è grande esattamente il millesimo numero primo?” ma piuttosto “quanto è grande approssimativamente il millesimo numero primo?” Per la precisione, formule esatte esistono e ne sono note diverse, ma per sapere che \(p_{1000} = 7919\) ci vuole l’età dell’universo e si consuma tutta l’energia che il sole ha mai prodotto e mai produrrà. La discussione dettagliata di una formula particolarmente famosa, quella di Gandhi (solo un omonimo del Mahatma), si può trovare in [4 ]A. Zaccagnini, Macchine che producono numeri primi, Matematica, Cultura e Società 1 (2016), no. 1, 5–19.. Dal punto di vista del matematico, è meglio sapere che \(p_n \approx n (\log(n) + \log(\log(n)) – 1)\) quando \(n\) è grande e quindi che \(p_{1000} \approx 7840\), con un errore relativo dell’\(1\%\) circa e con calcoli molto semplici. C’è anche una versione piú accurata di questa formula approssimata che permette di dare un intervallo, relativamente corto, in cui si trova \(p_n\).

Normalmente si preferisce studiare la domanda originale di Gauss, che di fatto è equivalente a quella posta sopra: “quanti numeri primi ci sono approssimativamente fino ad \(n\)?” Questa quantità si chiama tradizionalmente \(\pi(n)\), in modo che \(\pi(10) = 4\), \(\pi(100) = 25\) e \(\pi(1000) = 168\). Ricordiamo che per motivi formali si preferisce non considerare primo il numero \(1\). Le informazioni su \(p_n\) e \(\pi(n)\), pur non essendo completamente interscambiabili, sono strettamente legate fra loro: per esempio, possiamo dire che \(p_{1000} = 7919\) oppure che \(\pi(7919) = 1000\). In generale, \(\pi(p_n) = n\), per definizione.

Le risposte di Legendre e Gauss furono rispettivamente \[\pi(n)

\approx

\frac n{\log n}

\qquad\text{e}\qquad

\pi(n)

\approx

{\mathrm{li}}(n)

=

\int_2^n \frac{\mathrm{d} x}{\log x},\] in entrambi i casi per \(n \to +\infty\). Integrando una volta per parti e facendo qualche stima, oppure utilizzando il Teorema di de l’Hôpital, si vede subito che le due formulazioni si “equivalgono,” cioè che il rapporto tra le due funzioni a secondo membro qui sopra tende ad \(1\) quando \(n \to +\infty\). Grazie al Teorema dei Numeri Primi, dimostrato alla fine del XIX secolo, la risposta di Gauss, però, è piú precisa perché \[\pi(n) – \frac n{\log n}

\approx

\frac n{(\log n)^2},\] mentre la differenza \(\pi(n) – {\mathrm{li}}(n)\) è molto piú piccola. Quanto piú piccola? Non si sa esattamente!

Non si sa esattamente ed è proprio questo il punto di tutta la questione. Come ricordavamo sopra, la Congettura di Riemann ha molte formulazioni equivalenti, alcune relativamente semplici da spiegare, altre molto piú profonde. In termini dell’accuratezza con cui \({\mathrm{li}}(n)\) approssima \(\pi(n)\), possiamo dire che la Congettura di Riemann vale se e soltanto se esiste un numero reale positivo \(C\) tale che \[\bigl\vert \pi(n) – {\mathrm{li}}(n) \bigr\vert

\le

C n^{1 / 2} \log n\] per ogni \(n \ge 2\). Per dare un’idea della distanza tra quello che si vorrebbe sapere e quello si sa al momento attuale, riportiamo la versione piú forte del Teorema dei Numeri Primi oggi nota. Esistono due costanti positive \(C\) e \(c\) tali che \[\bigl\vert \pi(n) – {\mathrm{li}}(n) \bigr\vert

\le

C n \exp \Bigl( -c \frac{(\log n)^{3/5}}{(\log\log n)^{1/5}} \Bigr)\] per ogni \(n \ge 3\). La funzione a secondo membro qui sopra è certamente una delle piú orribili mai comparse in Teoria dei Numeri; ma, considerazioni estetiche a parte, il guaio è che si tratta di una funzione molto grande, in effetti troppo grande per essere utile in molte applicazioni. Chi avrà la pazienza di leggere questo articolo fino in fondo, scoprirà da dove proviene questa funzione.

Diamo un po’ di numeri

Questa tabella mostra i valori calcolati di \(\pi(n)\) quando \(n\) è una potenza di \(10\) con esponente intero fra \(1\) e \(25\) e l’errore di approssimazione commesso stimando \(\pi(n)\) con \({\mathrm{li}}(n)\). La Congettura di Riemann può essere espressa, in modo impreciso ma pittoresco, dicendo che su ciascuna riga il numero di cifre della quantità all’estrema destra è circa la metà del numero di cifre della quantità al centro.

È piú complicato, ma non impossibile, spiegare nello stesso linguaggio quello che segue dalla versione citata sopra del Teorema dei Numeri Primi. Chiamiamo \(a\) il numero di cifre della quantità al centro e \(b\) il numero di cifre della quantità a destra su una qualsiasi delle righe. Trascurando qualche fattore logaritmico, abbiamo, piú o meno, che \(b \le a – a^{3/5}\), da confrontare con la disuguaglianza molto piú forte che segue dalla Congettura di Riemann, e cioè \(b \le a / 2\).

I Lettori non si lascino ingannare dal fatto che i numeri a destra sono tutti positivi, come è stato effettivamente congetturato da Gauss, che disponeva solo dei dati che corrispondono alle prime 6 o 7 righe qui sopra. Infatti, John E. Littlewood ha dimostrato nel 1914 che \({\mathrm{li}}(n) – \pi(n)\) cambia segno infinite volte. Sulla base di quanto dimostrato nel 2000 da Bays & Hudson [5 ]Carter Bays and Richard H. Hudson, A new bound for the smallest x with π(x) > li(x), Math. Comp. 69 (2000), no. 231, 1285–1296 (electronic)., il primo valore negativo nella colonna di destra dovrebbe apparire intorno alla 316-ma riga …Questo è uno dei motivi per cui chiunque tenti di affrontare uno dei grandi problemi aperti della Teoria Analitica dei Numeri usando solo un computer andrà incontro ad una robusta dose di scetticismo.

Perché la Congettura di Riemann è importante?

Ricordiamo che si tratta di un problema aperto da 160 anni, e che ha ricadute su molti risultati della Teoria Analitica dei Numeri ma non solo. Molti teoremi, inclusi quasi tutti quelli piú recenti del secondo autore di questo articolo, hanno due versioni: la prima è incondizionale, cioè non si aggiunge la Congettura di Riemann tra le ipotesi. La seconda versione, invece, è condizionale, cioè si suppone tra le ipotesi che la Congettura sia vera: questa seconda versione è solitamente molto piú forte della prima. Abbiamo incontrato sopra il caso piú celebre di questa situazione: la versione incondizionale del Teorema dei Numeri Primi è estremamente piú debole di quella condizionale.

A molti piacerebbe poter fare a meno di questo doppione.

Perché la Congettura di Riemann è difficile?

Questa non è una cosa facile da spiegare: sono stati tentati molti approcci, anche generalizzando leggermente il problema, ma finora non hanno funzionato; nel caso di alcune funzioni “simili” alla funzione zeta di Riemann, André Weil ha dimostrato che vale l’analogo della Congettura di Riemann; in altri casi, cioè per altre funzioni che in qualche modo somigliano alla funzione zeta, viceversa, sappiamo che l’analogo della Congettura non vale. Probabilmente, un criterio fondamentale risulterà l’avere o meno il prodotto di Eulero, che discutiamo in un paragrafo successivo.

Per dare un’idea della difficoltà del problema, raccontiamo un aneddoto su David Hilbert, uno dei matematici piú famosi vissuti a cavallo fra il XIX e il XX secolo. Secondo una leggenda tedesca, l’imperatore Federico I Barbarossa non è morto nelle crociate ma è nascosto in una caverna ed è pronto a tornare in difesa della Germania, in caso di necessità, anche dopo secoli. Qualcuno ha chiesto ad Hilbert che cosa farebbe, se potesse tornare a vivere, come Barbarossa, dopo qualche centinaio di anni e Hilbert ha risposto: “La prima cosa che farei è chiedere se nel frattempo qualcuno ha dimostrato la Congettura di Riemann!”

Questa risposta dimostra la consapevolezza dei grandi matematici di essere di fronte ad un problema estremamente difficile. È interessante notare che questa stessa consapevolezza non c’era, piú o meno contemporaneamente, fra i matematici inglesi. Infatti, Littlewood racconta che il suo relatore, E. W. Barnes, senza rendersi conto della difficoltà della cosa, gli aveva assegnato la dimostrazione della Congettura di Riemann come tesi di dottorato, intorno al 1906! La situazione è cambiata drasticamente a partire dal 1909 con la pubblicazione dei libri di Edmund Landau.

Littlewood viene alla mente in questo contesto anche perché ha pubblicato il suo ultimo articolo di ricerca nel 1972, cioè quando aveva 87 anni; non è inaudito che un grande matematico pubblichi ancora in tarda età. Il primato spetta ora al matematico austriaco Leopold Vietoris, che ha pubblicato un articolo di ricerca sulle somme trigonometriche a 103 anni di età!

Conseguenze interne alla matematica

La maggior parte delle conseguenze della Congettura sono interne alla matematica; al massimo, può servire alla dimostrazione rigorosa della complessità computazionale di qualche algoritmo. Sono le nostre conoscenze ad essere imperfette.

La verità della Congettura di Riemann implica che certi algoritmi di interesse crittografico hanno una complessità computazionale piuttosto bassa; in altre parole, se è vera la Congettura di Riemann si sa con certezza che questi algoritmi terminano dopo un certo numero di operazioni relativamente contenuto. Al momento non si sa fare la stessa dimostrazione senza usare la Congettura di Riemann, e quindi la stima incondizionale per la complessità di questi algoritmi è di gran lunga peggiore di quella condizionale. Questo fatto non ha conseguenze pratiche sul tempo di esecuzione dell’algoritmo stesso, che funziona bene lo stesso, che la Congettura sia vera o no, ma ci dice solo che le attuali conoscenze certe sono insufficienti e che sarebbe desiderabile saperne di piú. Non si può affatto escludere che prima o poi qualcuno trovi una dimostrazione, magari molto piú complicata, che vale anche senza supporre la Congettura di Riemann.

In particolare, la Congettura non ha conseguenze sulla sicurezza dei protocolli crittografici: ci teniamo a sottolineare questo fatto importante che è stato piú volte frainteso.

Conseguenze sulla vita quotidiana

In altre parole, nonostante certe notizie piuttosto fantasiose che circolano in rete, la dimostrazione della Congettura di Riemann non significa che i nostri dati personali sono in pericolo e che dobbiamo cambiare tutte le nostre password. Cambiare le password con regolarità è una prassi prudente, ma non dovremo farlo piú spesso se la dimostrazione di Atiyah risulterà corretta.

Il processo di validazione della ricerca in matematica (e non solo)

Cerchiamo ora di capire il processo di validazione di un risultato scientifico. Ovvero, cosa succede da quando si dimostra un risultato a quando questo viene accettato dalla comunità scientifica?

Un passaggio facoltativo, ma utile per definire questioni di priorità nella scoperta di un risultato, è la pre-pubblicazione on-line su piattaforme dedicate. La piú famosa e utilizzata è arXiv (www.arxiv.org), piattaforma della Cornell University, attiva dall’agosto 1991 e contenente quasi un milione e mezzo di articoli di ricerca di fisica, matematica, informatica, biologia, finanza, statistica, ingegneria elettronica ed economia. L’utilizzo di questa o altre piattaforme (piú settoriali) garantisce anche una visibilità immediata dei risultati ottenuti, con conseguente aumento della velocità di disseminazione della ricerca e possibilità di trovare nuove collaborazioni rapidamente.

La pubblicazione su tali piattaforme on-line non prevede però alcun tipo di validazione della ricerca ivi pubblicata.

Parallelamente a questo passaggio, si invia il proprio articolo ad una delle moltissime riviste specialistiche pubblicate in tutto il mondo. Vi sono sia riviste generaliste (ovvero che si occupano di ogni settore della matematica), sia riviste settoriali. Le riviste sono piú o meno prestigiose e, mentre la correttezza dei risultati è o per lo meno dovrebbe essere condizione necessaria per pubblicare su una qualsiasi rivista scientifica, non è assolutamente una condizione sufficiente. La produzione scientifica mondiale è amplissima (per averne un’idea, nel 2017 su arXiv sono apparsi 34364 articoli di matematica, una media di quasi 100 al giorno) e solo risultati di livello e interesse notevole possono trovare spazio sulle riviste piú prestigiose. Solitamente si può inviare un articolo ad una sola rivista e si dichiara che nessun altro lo sta prendendo in considerazione per la pubblicazione.

Una volta che uno dei membri (editor) del comitato editoriale di una rivista riceve un articolo, ne fa una valutazione preventiva e in seguito lo invia ad uno o piú esperti anonimi (detti referee, arbitro), che hanno il compito di giudicare sia la correttezza dei risultati, sia il livello e l’interesse degli stessi. Il processo di valutazione degli articoli da parte dei referee è detto peer review (revisione dei pari).

I referee suggeriscono eventuali modifiche o correzioni da apportare all’articolo (o segnalano eventuali errori che lo rendono non accettabile). Sulla base del parere ricevuto dai referee, l’editor decide se accettare l’articolo, chiedere delle modifiche all’articolo (e/o risposte alle osservazioni dei referee) oppure rifiutare l’articolo, sulla base di motivazioni piú o meno gravi (che possono spaziare dall’articolo con risultati sbagliati all’articolo corretto e interessante, ma non ritenuto adatto al livello del prestigio della rivista a cui era stato inviato o troppo tecnico per il tipo di rivista).

Sulla base dei pareri ricevuti, l’autore apporta le correzioni richieste ed invia una eventuale seconda versione alla stessa rivista oppure ad un’altra, di livello inferiore o piú specialistica.

Una volta che l’editor accetta il lavoro presentato, l’articolo viene impaginato con lo stile della rivista, viene rimandato all’autore per un ultimo controllo e infine pubblicato effettivamente sulla rivista (spesso immediatamente nella versione on-line e in seguito su quella cartacea). Sulla versione definitiva compaiono le date di invio (submission) dell’articolo alla rivista e di accettazione, sempre per questioni di priorità.

Il processo di referaggio (dall’invio dell’articolo alla sua accettazione) può durare da alcuni mesi fino ad anni, per la difficoltà di trovare referee competenti e intenzionati ad effettuare il referaggio (che è un lavoro totalmente gratuito ed anonimo) e la scarsità di tempo dei referee stessi. Proprio la lunga durata di questo processo ha fatto sì che le piattaforme di pre-pubblicazione avessero tanto successo.

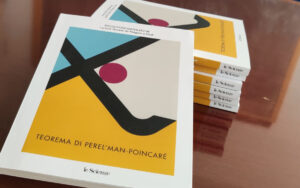

Ovviamente nel caso di articoli che asseriscono di contenere risposte a congetture molto importanti (come nel caso della Congettura di Riemann, e come è stato in passato per l’Ultimo Teorema di Fermat o per la Congettura di Poincaré) la cautela è d’obbligo e il processo di peer review è ancora piú attento del solito, con referee multipli, con competenze diversificate tra loro. Spesso è anche capitato che lo stesso articolo venisse diviso in piú parti consegnate poi a referee differenti. Il lavoro di validazione in questi casi (a meno che venga trovato subito un errore grave) dura degli anni.

La procedura della peer review è la stessa per tutti, che si sia un dottorando alla prima pubblicazione o una medaglia Fields e il risultato —almeno in teoria— dovrebbe essere indipendente dal prestigio dell’autore. Non vale, in Matematica e nella Scienza in generale, il principio dell’ipse dixit. Ovviamente, poi, gli editor e i referee sono esseri umani e come tali possono essere inconsciamente influenzati e commettere errori. La procedura è studiata per cercare di ridurre tali errori al minimo e, nel caso di risultati particolarmente significativi e/o di riviste particolarmente prestigiose, l’elevato numero di referee diminuisce la probabilità di errori.

Il procedimento della peer review si basa sull’assunto che tutti gli attori in gioco siano corretti e non abbiano secondi fini nel loro comportamento. Purtroppo nell’ultimo periodo varie pratiche per l’assunzione e la carriera nelle Università e negli enti di ricerca, basate sempre piú pesantemente sui freddi numeri (numero di pubblicazioni, numero di citazioni), che vanno ben oltre il già problematico publish or perish (pubblica o muori), rischiano di avere un forte effetto negativo sul processo di referaggio, sia in modo diretto e fraudolento (tentativo deliberato di pubblicare risultati falsi o plagiati da parte degli autori), sia in modo indiretto e inconscio (maggior favore mostrato dai referee verso articoli in cui vengono citati).

Se questi effetti negativi inizieranno ad essere troppo evidenti, probabilmente in futuro bisognerà trovare il modo di modificare il processo di validazione della ricerca, che si è stabilito come è oggi a seguito di una evoluzione durata svariati secoli. Niente di grave: al variare delle condizioni ambientali, tutto si evolve.

Quindi il processo di peer review non è esente da problemi, ma allo stato attuale garantisce una buona soluzione al problema della validazione della ricerca. Inoltre questo processo permette spesso di salvare delle buone idee presenti negli articoli, individuando e correggendo errori piú o meno veniali presenti nelle dimostrazioni. Nel caso di errori veniali, al referee anonimo rimane solo la gloria (anonima) del ringraziamento sull’articolo. Nel caso di errori piú gravi, non è infrequente che autore e referee lavorino insieme ad un nuovo articolo in cui si aggiri il problema emerso, affrontandolo in modo diverso. Nel caso della dimostrazione dell’Ultimo Teorema di Fermat, il referee Nick Katz ha discusso a lungo con Andrew Wiles, convincendolo infine di una lacuna, un passaggio non completamente giustificato nella sua dimostrazione. Ciò ha portato ad un nuovo periodo di lavoro per Andrew Wiles e infine alla dimostrazione corretta. Questo è indubbiamente un grande successo del processo di validazione in matematica.

Infine, ricordiamo ancora come il processo di peer review, come tutte le attività umane, non sia esente da errori. Questo è precisamente il motivo per cui il Clay Mathematical Institute prima di consegnare il premio da un milione di dollari per la risoluzione di uno dei sette problemi del millennio (tra i quali figura anche la Congettura di Riemann) fa passare due anni dalla pubblicazione della dimostrazione.

Infatti accade a volte che errori in dimostrazioni vengano scoperti dopo la pubblicazione, da matematici che cercano di utilizzare quei risultati per i propri lavori.

In definitiva, il processo di validazione della ricerca matematica è molto complesso e non completamente esente da errori, ma piú un risultato è importante e ha conseguenze per la matematica, piú rigorosamente viene controllato prima della pubblicazione e anche dopo la pubblicazione, dato che molti matematici cercheranno di usarlo e quindi si confronteranno con la dimostrazione. Quindi possiamo stare abbastanza tranquilli: può capitare di vedere pubblicati dei risultati sbagliati, ma o non saranno utilizzati (e quindi faranno un danno molto limitato) o la loro non validità verrà scoperta (e magari corretta) in tempi rapidi.

Do it yourself: Come dimostrare la Congettura di Riemann

Concludiamo con uno scherzoso invito a dimostrare la Congettura di Riemann partendo dal prodotto di Eulero. C’è una famosa identità scoperta da Eulero che è valida nel semipiano dei numeri complessi \(s\) per cui \(\Re(s) > 1\): \[\zeta(s)

=

\sum_{n \ge 1} \frac1{n^s}

=

\prod_p \Bigl( 1 – \frac1{p^s} \Bigr)^{-1}.\] Il prodotto a destra è fatto su tutti i numeri primi. La dimostrazione originale di Eulero, che pensava in termini di variabili reali, si basa sull’unicità della fattorizzazione degli interi in prodotti di numeri primi e sulla convergenza della serie geometrica; la dimostrazione resta valida cosí com’è, in realtà, per tutti i numeri complessi \(s\), non necessariamente reali, per cui \(\Re(s) > 1\). L’importanza di questa identità non può essere enfatizzata a sufficienza: Eulero ne dedusse immediatamente l’esistenza di infiniti numeri primi, usando un’argomentazione propria dell’Analisi Matematica, e quindi lontanissima da quella originale di Euclide, di natura prettamente aritmetica; cosí dette vita a quella parte della matematica che oggi chiamiamo Teoria Analitica dei Numeri.

La dimostrazione dipende dal fatto che se \(s\) è un numero reale allora \[\lim_{s \to 1+} \zeta(s)

=

+\infty,\] perché in pratica si ottiene la serie armonica, il prototipo delle serie divergenti. La dimostrazione rigorosa non è difficile, ma qui la omettiamo.

Se esistessero solo un numero finito di numeri primi, il prodotto qui sopra avrebbe un numero finito di fattori ed avrebbe un limite finito quando \(s \to 1+\), in contraddizione con quanto detto sopra. In effetti, questa dimostrazione qualitativa può essere trasformata in una dimostrazione quantitativa, come fece Eulero in persona, per dimostrare che la serie armonica, anche se limitata ai reciproci dei soli numeri primi, resta divergente! Con un po’ di pazienza è possibile ottenere risultati anche piú precisi di questo, che rimandiamo ad un’altra occasione.

Torniamo al prodotto di Eulero ed al semipiano dei numeri complessi \(s\) di parte reale \(\Re(s) > 1\). In effetti in questa regione \(\zeta(s) \ne 0\) proprio perché il prodotto converge e c’è un apposito teorema che garantisce che un prodotto convergente si annulla solo nei punti in cui si annulla uno dei fattori. I fattori hanno senso per \(\Re(s) > 0\) e non si annullano.

Il compito, dunque, è questo: estendere la validità del prodotto di Eulero alla retta \(\sigma = 1\) e alla sua sinistra. Infatti, se si riuscisse a dimostrare che il prodotto converge in una regione piú ampia di quella nota, automaticamente se ne potrebbe dedurre che la funzione \(\zeta\) non si annulla e questo ha importanti conseguenze sulla distribuzione dei numeri primi.

Non c’è bisogno di dire che si tratta di un compito difficilissimo: si veda il §3.15 del libro di Titchmarsh [6 ]E. C. Titchmarsh, The Theory of the Riemann Zeta–Function, second ed., Oxford University Press, Oxford, 1986. per capire la fatica che ci vuole a dimostrare che il prodotto converge alla quantità giusta sulla retta \(\Re(s) = 1\) (privata del punto \(s = 1\)).

Anche questo risultato, molto parziale, ha la sua utilità. Se si riesce a dimostrare non solo che \(\zeta(1 + {\mathrm{i}}t) \ne 0\) per ogni \(t \ne 0\), ma anche che \(\vert \zeta(1 + {\mathrm{i}}t) \vert\) non è troppo piccolo e che \(\vert \zeta’(1 + {\mathrm{i}}t) \vert\) non è troppo grande, allora abbiamo ottenuto in ogni caso un’informazione utile. Se \(f\) è una funzione derivabile, \(f(0) = 1\) ed \(\vert f'(x) \vert \le 1\) per ogni \(x\) reale, è possibile che \(f(1 / 2) = 0\)? No, per il Teorema di Lagrange: infatti, esiste \(\xi \in (0, 1)\) tale che \[\frac{f(1 / 2) – f(0)}{1/2 – 0}

=

f'(\xi).\] Sostituendo le ipotesi \(f(0) = 1\) e \(f(1 / 2) = 0\), troveremmo \(f'(\xi) = -2\), che è contraddittorio con l’ipotesi su \(f’\). Questa dimostrazione non funziona cosí com’è per le funzioni complesse (il Teorema di Lagrange non vale perché si basa sull’ordinamento dei numeri reali), ma basta usare il Teorema Fondamentale del Calcolo Integrale \[f(z_1) = f(z_0) + \int_{z_0}^{z_1} f'(z) \, \mathrm{d} z\] e la disuguaglianza trangolare \[\vert f(z_1) – f(z_0) \vert

=

\Bigl\vert \int_{z_0}^{z_1} f'(z) \, \mathrm{d} z \Bigr\vert

\le

\vert z_1 – z_0 \vert \cdot \max_z \vert f'(z) \vert,\] dove il massimo è fatto sul segmento del piano complesso di estremi \(z_0\) e \(z_1\). Quindi \(f(z_1) = 0\) implica che \(\vert z_1 – z_0 \vert \ge \vert f(z_0) \vert / \max_z \vert f'(z) \vert\), cioè che non ci sono zeri di \(f\) molto vicini a \(z_0\).

Analogamente, anche se la cosa è ben piú complicata, trovare una limitazione quantitativa dal basso per \(\vert \zeta(1 + {\mathrm{i}}t) \vert\), in termini di \(t\), e dall’alto per \(\vert \zeta’(1 + {\mathrm{i}}t) \vert\), permette di dire che la funzione \(\zeta\) non si annulla neppure in una sottilissima regione alla sinistra della retta \(\sigma = 1\), detta regione libera da zeri. La Congettura di Riemann può essere formulata dicendo che la regione di cui parliamo ha ampiezza \(\frac12\) qualunque sia l’altezza \(t\); sarebbe già un risultato straordinario dimostrare che l’ampiezza è almeno un milionesimo ad ogni altezza \(t\).

L’orribile funzione che compare nella maggiorazione per \(\pi(n) – {\mathrm{li}}(n)\) è legata in modo “meccanico” al fatto che negli anni ’50 del XX secolo i matematici sovietici I.M. Vinogradov e N.M. Korobov dimostrarono che l’ampiezza della regione libera da zeri ad altezza \(t > 10\) vale almeno \(c / \bigl( (\log t)^{2/3} (\log\log t)^{1/3} \bigr)\), dove \(c\) è una costante positiva. Per esempio, l’esponente \(3/5\) nella limitazione \(b \le a – a^{3/5}\) (che abbiamo visto sopra quando abbiamo parlato della relazione fra il numero di cifre di \(\pi(n)\) e quello di \({\mathrm{li}}(n) – \pi(n)\)) non è altro che il valore di \(1 / (1 + 2 / 3) = 3 / 5\). I dettagli sono esposti in [7 ]A. Zaccagnini, Breve storia dei numeri primi, Ithaca: Viaggio nella Scienza III (2014), 67–83 .

Per concludere

In conclusione, anche se le serrate verifiche a cui sarà sottoposta la dimostrazione di Atiyah riveleranno che è sbagliata, non tutto è necessariamente perduto: è possibile che qualche idea sia “riciclabile” per ottenere qualche risultato piú debole della Congettura di Riemann ma pur sempre utile. Non sarebbe la prima volta che succede.

Alberto Saracco & Alessandro Zaccagnini. Università di Parma

Note e riferimenti

| ⇧1 | A. Zaccagnini, Una versione elementare della Congettura di Riemann, MaddMaths! (2016) |

|---|---|

| ⇧2 | A. Zaccagnini, C’è veramente un nuovo approccio alla Congettura di Riemann?, MaddMaths! (2017) |

| ⇧3 | A. Zaccagnini, Scacco matto all’Ipotesi di Riemann in tre semplici (?) mosse, MaddMaths! (2018) |

| ⇧4 | A. Zaccagnini, Macchine che producono numeri primi, Matematica, Cultura e Società 1 (2016), no. 1, 5–19. |

| ⇧5 | Carter Bays and Richard H. Hudson, A new bound for the smallest x with π(x) > li(x), Math. Comp. 69 (2000), no. 231, 1285–1296 (electronic). |

| ⇧6 | E. C. Titchmarsh, The Theory of the Riemann Zeta–Function, second ed., Oxford University Press, Oxford, 1986. |

| ⇧7 | A. Zaccagnini, Breve storia dei numeri primi, Ithaca: Viaggio nella Scienza III (2014), 67–83 |

EGREGIO PROF. ZACCAGNINI, HO UN QUESITO DA SOTTOPORRE, SPERANDO DI RIUSCIRE A SPIEGARMI E CONFIDANDO NEL SUO AIUTO.

RIGUARDA LA CONTINUAZIONE ANALITICA DELLA Z DI RIEMANN.

HO TROVATO UN SEMPLICE ESEMPIO CHE CONSENTE DI LEGARE LA Z DI RIEMANN ALLA ETA DI DIRICHLET, CONSENTENDO LA CONTINUAZIONE ANALITICA FINO A PARTE REALE UGUALE A ZERO DELL’ ESPONENTE S DELLA Z (IN ORIGINE LA PARTE REALE DELL’ ESPONENTE DOVEVA ESSERE >1).

NON MI E’ CHIARO SE QUESTA RELAZIONE POSSA ESSERE APPLICATA E VALERE ANCHE PER I VALORI NEGATIVI DELLA PARTE REALE DI S, IN MODO DA COMPRENDERE I COSIDETTI ZERI BANALI OTTENUTI ATTRAVERSO L’ EQUAZIONE FUNZIONALE (OSSIA DI ESTENDERE IL DOMINIO ALLA PARTE REALE NEGATIVA, DEL PIANO COMPLESSO).

RINGRAZIO ANTICIPATAMENTE E MI PERMETTO ATTRAVERSO QUESTO SITO DI FARE GLI AUGURI DI NATALE A TUTTI.

FABRIZIO

Gentile Professor Zaccagnini nel suo ultimo interessantissimo articolo ad un certo punto mi sono soffermato sulla parte intitolata Do it your self Come dimostrare la Congettura di Riemann: uno scherzoso invito a dimostrare la Congettura di Riemann a partire dal prodotto di Eulero estendendo la convergenza del prodotto oltre la retta R(s)=1 cosa che come ha detto lei è estremamente complicata.

Se invece di utilizzare il prodotto di Eulero si provasse ad utilizzare l’equazione Funzionale?

Odlyzko ha verificato che nella striscia critica di altezza t=10^12 gli zeri sono tutti sulla retta critica.

Imponendo s0=sigma0+it con 0<sigma10^12 t.c.

zeta(s0)=lambda(s0)zeta(1-s0)=0 e zeta(1-s0)=lambda(1-s0)zeta(s0)=0

con

modulolambda(s0)modulolambda(1-s0)=1 e nell’intorno di s0 modulolambda(s)modulolambda(1-s)=1

Allora RH è falsa

Nel caso in cui ,invece, sempre imponendo

zeta(s0)=lambda(s0)zeta(1-s0)=0 e zeta(1-s0)=lambda(1-s0)zeta(s0)=0

ottenessi

modulolambda(s0)modulolambda(1-s0)=1 e in un intorno di s0 almeno un valore di s t.c

modulolambda(s)modulolambda(1-s)≠1(ASSURDO)

RH è vera?

Grazie.

Il prodotto di Eulero e l’equazione funzionale sono proprietà della funzione zeta che interagiscono solo fino ad un certo punto. La funzione chiamata lambda nel commento ha la proprietà che lambda(s) lambda(1-s)=1 per ogni s complesso; non riesco a capire come si possa dimostrare che il modulo del prodotto sia diverso da 1. Inoltre, non si capisce come e perché sia necessario il risultato di Odlyzko e non sia sufficiente, invece, sapere che i primi 10 zeri di zeta sono sulla retta critica.