Recentemente sì è parlato molto, per esempio a Radio3 Scienza, di una nuova ricerca pubblicata sulla rivista Science Advance in cui è stato studiato un metodo che sfrutta l’intelligenza artificiale e l’osservazione diretta del cervello tramite risonanza magnetica, per rilevare gli effetti dell’espressione di alcuni geni del cromosoma 16, che sappiamo essere correlati a un aumento del rischio di autismo e che determinerebbe alterazioni nel volume della corteccia cerebrale. Per questo molti organi di informazione hanno titolato con frasi del tipo “decifrato il codice genetico dell’autismo”. Pochi però si sono soffermati sugli aspetti più strettamente matematici della ricerca, che coinvolge strumenti sofisticati di teoria della misura. Per rimediare, abbiamo chiesto di parlarcene a Giovanni Franzina che ci ha preparato una panoramica molto ampia sui metodi matematici per “vedere l’invisibile”.

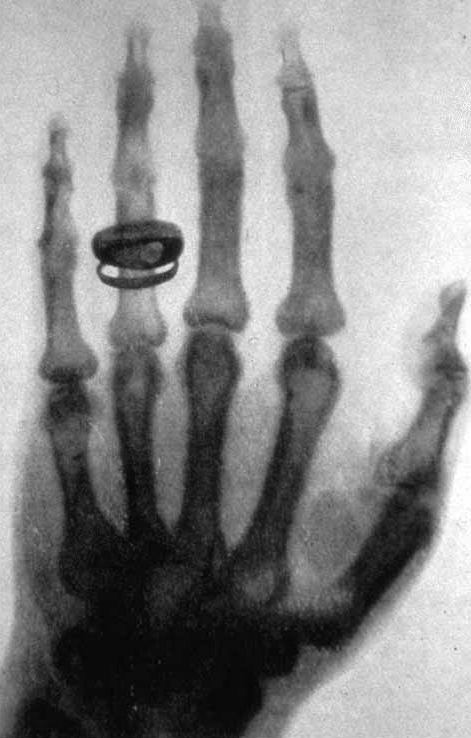

Dalla scoperta dei raggi X nel 1895 da parte del fisico tedesco Wilhelm Röntgen, insignito per questo risultato del premio Nobel nel 1901, sono stati introdotti diversi metodi diagnostici che permettono ai medici di visualizzare l’interno del corpo umano, superando i limiti naturali della nostra vista. Il funzionamento di questa tecnica, all’inizio, era oscuro al suo primo conoscitore che, difatti, per la scelta del nome utilizzò il simbolo dell’incognita per antonomasia in matematica: la X, appunto.

Figura 1. dettaglio dell’anello nuziale sulla mano della moglie di Rötgen, ripresa per caso dal fisico in quella che è stata la prima radiografia della storia nel 1895. Immagine di pubblico dominio.

A non essere compresi, per un certo periodo, furono anche gli effetti collaterali dell’esposizione a radiazioni ionizzanti. Come per le radiografie, anche altre tecniche di diagnostica per immagini introdotte successivamente implicano questo rischio che però nel tempo i medici hanno saputo mitigare soppesandolo con i benefici di una diagnosi più accurata. Questo è il caso, per esempio, della Tomografia Assiale Computerizzata (TAC), della Scintigrafia e della Tomografia a emissione di positroni (PET) che oggi forniscono un contributo dirimente in radiologia.

Altri metodi, invece, non presentano rischi di questo tipo: è il caso delle ecografie, ma anche delle magnetoencefalografie (MEG) e delle tomografie a impedenza elettrica (EEG). Soprattutto, fa parte di questa categoria la risonanza magnetica per immagini (RMI), esame elettivo in svariati ambiti della medicina, come la neurologia e l’oncologia, non solo per i vantaggi legati alla mitigazione del rischio radiologico ma anche per la sua notevole precisione nel differenziare i diversi tipi di tessuto.

I problemi inversi per il medical imaging

A supportare le moderne tecniche di diagnostica per immagini non c’è un percorso euristico accidentale, come quello che ha portato alla prima radiografia della storia, ma un processo scientifico pianificato: le procedure infatti sono il frutto di un progetto consapevole che sfrutta complesse teorie fisiche applicandole alla produzione di immagini. Un’altra differenza fra i RX e queste tecniche più moderne è che queste ultime richiedono, a valle, un aiuto da parte della matematica, la quale interviene risolvendo un problema inverso: ricostuire, partendo dai dati grezzi ottenuti con l’esame, un’immagine interpretabile a vista da parte del personale medico. Senza i modelli matematici e i relativi software, il risultato di una risonanza magnetica (così come quello di TAC, PET, EEG, MEG…) resterebbe un aggregato informe di dati su una memoria informatica; l’aiuto della matematica consiste nel dar forma a questi dati perché possano essere interpretati da un essere umano: un medico, con la sua imprescindibile esperienza professionale. Ma anche, suo malgrado, con i limiti imposti dalle caratteristiche delle sue capacità naturali di percezione visiva.

Si commetterebbe un errore di visione prospettica nel pensare che il ruolo della matematica attuale si limiti al perfezionamento progressivo di questo processo diagnostico suggerendo tecnologie via via più precise. Nell’epoca dei big data, per disvelare l’invisibile con maggiore precisione la matematica può ripartire dai dati grezzi, facendoli analizzare però non più solo a un essere umano, col tramite di un’immagine visibile, ma anche a un sistema automatico. Questa idea, che non rimpiazza ma integra la soluzione di problemi inversi, è infatti molto praticata nel contesto biomedico. Noi ci siamo imbattuti in un contributo che va in questa direzione combinando l’apprendimento statistico con il trasporto ottimale di massa. A questo punto, occorre fare chiarezza su questi due ingredienti. Il primo è la teoria alla base dello sviluppo della cosiddetta intelligenza artificiale, le cui applicazioni sono quotidianamente sotto gli occhi di tutti; incidentalmente, l’8 ottobre 2024 il premio Nobel per la Fisica è andato a John J. Hopfield e Geoffrey E. Hinton proprio per le loro ricerche nel campo delle reti neurali artificiali, e, l’indomani, sono stati premiati David Baker, Demis Hassabis e John Jumper con il premio Nobel per la Chimica per le loro applicazioni del machine learning allo studio delle proteine. Il secondo ingrediente è una tecnica matematica meno nota al grande pubblico.

Il trasporto ottimo (di immagini diagnostiche)

Il problema del trasporto ottimo fu inizialmente formulato da Gaspard Monge nel contesto della geometria descrittiva in un’ottica orientata alle applicazioni militari. Per la costruzione di fortificazioni, il matematico francese propose nel 1781 un modello nel quale il costo totale era determinato dalla somma di singoli costi unitari, ciascuno proporzionale alla distanza da percorrere con ogni singola unità di massa dal deposito di materiale fino al punto per essa prescelto nel cantiere, ipotizzando lo scenario di un percorso sgombro da ostacoli. Cambiare strategia di trasporto, in questa formulazione, significava modificare per una o più delle singole “unità di massa” la collocazione finale nel cantiere; in questo modo, a strategie differenti corrispondevano costi totali differenti: il problema di ottimizzazione consisteva nella ricerca della strategia di costo minimo.

La richiesta implicita nel modello di Monge, che ad ogni punto di partenza dovesse corrispondere univocamente una posizione di arrivo, irrigidiva la questione da un punto di vista matematico, rendendo difficile persino il proposito di dimostrare l’esistenza di una strategia ottimale. Per uno sviluppo sulla questione è toccato aspettare il 1939, quando lavorando alla realizzazione del terzo piano quinquennale sovietico Leonid V. Kantorovich propose un modello per l’ottimizzazione del trasferimento di merci sotto il vincolo di bilancio di domanda e offerta. Nella sua ricerca, che gli è valsa il premio della Banca di Svezia per le scienze economiche (il cosiddetto premio Nobel per l’economia) nel 1975, ha posto le basi per l’ottimizzazione lineare moderna proponendo dei modelli matematici che generalizzano la versione discreta del problema di Monge, rendendo possibile nel seguito la soluzione di quest’ultimo da parte dei matematici: nel caso della formulazione originaria di Monge, in particolare, il problema è stato risolto su queste basi da Luigi Ambrosio nel 2003.

La teoria del trasporto ottimo ha schiuso un mondo inesplorato, aperto dai lavori fondamentali di Yann Brenier, e ben descritto nelle sue monografie da Cédric Villani, matematico francese e medaglia Fields nel 2010 (incidentalmente, fra le applicazioni del trasporto ottimo si annoverano anche i risultati ottenuti dall’ultima medaglia Fields di formazione accademica italiana, Alessio Figalli, premiato nel 2018). Queste esplorazioni, ancora in corso, hanno riguardato la relazione fra geometria e probabilità, l’analisi in spazi metrici, le equazioni alle derivate parziali, la statistica inferenziale, e molto altro che sfugge a chi scrive.

In particolare, la geometria del trasporto ottimo ha il pregio di potenziare la nostra comprensione delle distribuzioni (distribuzioni di massa in uno spazio fisico, distribuzioni di una variabile aleatoria…) strutturandone lo spazio con una distanza molto speciale, definita appunto calcolando il costo di trasporto ottimo di una densità sull’altra (o viceversa). Con questa struttura, grazie al cosiddetto calcolo di Otto (con riferimento alle idee del matematico tedesco Felix Otto), la geometria dello spazio fisico, dove avviene materialmente il trasporto di massa, viene innalzata a un iperuranio formato da singoli oggetti, matematicamente rappresentati da misure di probabilità, i quali possono sintetizzare molte cose differenti: densità di traffico veicolare, distribuzioni di variabili aleatorie multivariate, testi da generare casualmente con un sistema informatico generativo.

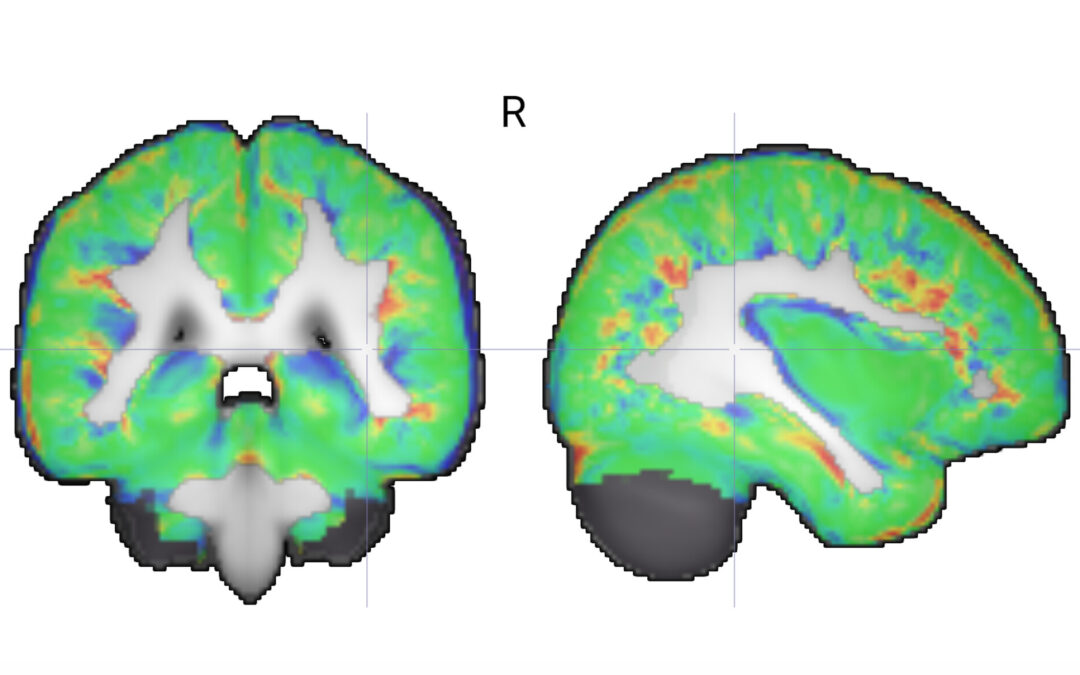

Anche l’immagine di una RMI può essere modellata come una distribuzione di colore. Le distanze di trasporto possono quindi essere utilizzate per confrontare diverse immagini da RMI quantificandone le differenze, quando si è alla ricerca di anomalie patologiche. La geometria del trasporto permette di esplorare lo spazio delle immagini, in particolare per individuare il tragitto ottimale che collega due immagini date: una specie di animazione, in cui ogni singolo frame rappresenta un’immagine intermedia generata artificialmente.

Riconoscimento di pattern correlati ai disturbi dello spettro autistico

Le possibilità offerte dalla geometria del trasporto ottimo sono utilizzate in nell’articolo di S. Kundu & co. con lo scopo di addestrare un sistema automatico a riconoscere con una risonanza magnetica cerebrale l’eventuale presenza di indizi di disturbi dello spettro autistico (ASD), in modo da fornire risultati interpretabili da parte del personale medico. Partiamo dal fatto che la letteratura medica tende al consenso sulla natura multifattoriale dell’eziopatogenesi di questi disturbi, per i quali risultano non trascurabili i fattori ambientali ed epigenetici, esistono comunque delle ipotesi su certe concause ereditarie, riguardanti alcuni specifici geni. In particolar modo, le variazioni del numero di copie del gene posizionato nella regione 16p11.2 sono state correlate a un notevole aumento di rischio di una diagnosi di disturbi dello spettro autistico. Sebbene al momento non sia noto alcun meccanismo biologico causato da cancellazioni o duplicazioni di copie di questo gene, la correlazione statistica è forte e rende interessante la ricerca di indizi della presenza dell’anomalia con test non invasivi, come la RMI.

A disposizione dei ricercatori ci sono banche dati di esami diagnostici (di pazienti in cui è riscontrata l’anomalia, e di soggetti del gruppo di controllo) che, grazie a vari metodi consolidati di apprendimento statistico supervisionato, permettono di addestrare sistemi automatici a classificare le immagini da RMI per stabilire l’eventuale presenza di questa anomalia genetica. Compiuto in questo modo l’addestramento, si otterranno risultati diversi a seconda della maniera prescelta in partenza per descrivere matematicamente i dati grezzi. Oltre al problema dell’accuratezza di questo procedimento, ne esiste un altro: nulla garantisce che la classificazione decretata dal sistema automatico risulti comprensibile al personale medico.

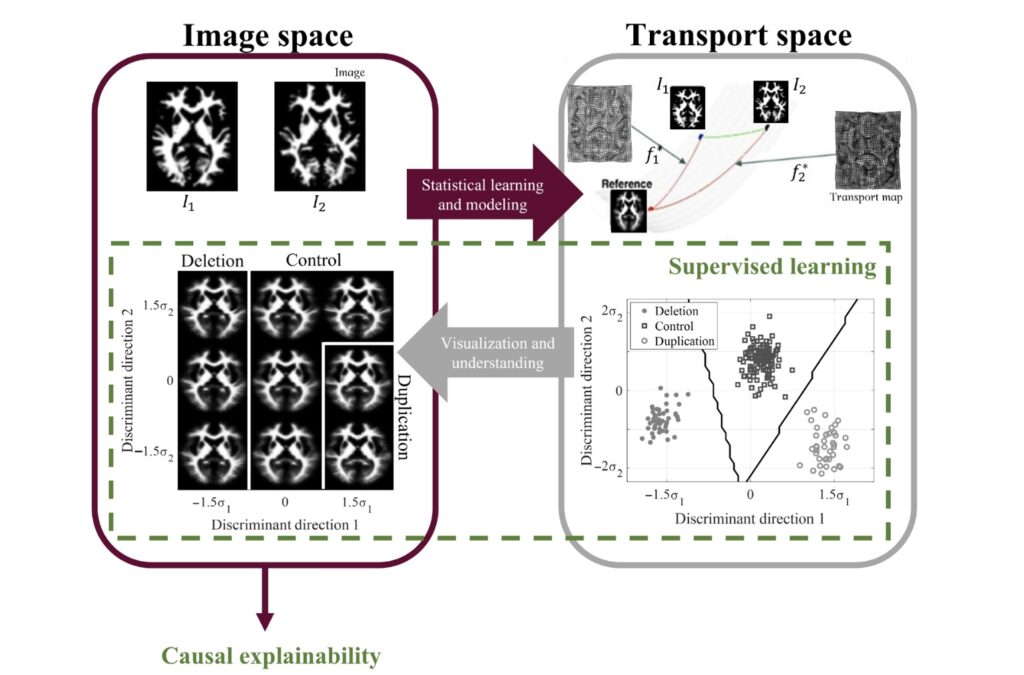

Figura 2. il metodo di S. Kundu et. al. classifica le mappe ottimali per il trasporto di un’immagine diagnostica su un’immagine di riferimento: le superfici di separazione fra casi fisiologici e patologici sono evidenziate nel dominio del trasporto e usate per separare le risonanze magnetiche dei pazienti in cui il sistema prevede la presenza di una variazione del numero di copie di un certo gene da tutte le altre. Immagine tratta dall’articolo S. Kundu & co .

L’addestramento e l’utilizzo di queste procedure di classificazione, sul piano pratico, prevedono di dare in pasto le immagini a un sistema di machine learning dopo averle tradotte in un certo tipo di dati vettoriali. La novità del metodo proposto dal team di S. Kundu sta semplicemente nella maniera di tradurre queste immagini di risonanze in dati: la scelta operata è quella di descrivere ogni immagine come un punto nello spazio delle distribuzioni di probabilità, strutturato come illustrato sopra secondo la teoria del trasporto ottimo. Terminato l’addestramento, il sistema può essere utilizzato per rilevare l’eventuale anomalia genetica là dove l’occhio medico, per quanto esperto, non saprebbe riconoscerla. Testato con nuove immagini, dà risultati che possono essere validati a posteriori con tecniche molecolari (reazione a catena della polimerasi) per la presenza di duplicazioni o delezioni del gene 16p11.2 e, in questo articolo, si afferma il riscontro di un’affidabilità dell’esito positivo superiore all’88.5% (cfr. Tab. 3 dell’articolo).

Interpretabilità degli algoritmi

Secondo questo studio, l’accuratezza non sarebbe poi l’unico pregio del combinare machine learning e trasporto ottimo. Un altro vantaggio sarebbe rappresentato dalla possibilità di rendere più trasparenti gli algoritmi utilizzati. Il metodo scelto fornirebbe infatti una potenzialità “generativa”: grazie alle equazioni del trasporto ottimo si ha la possibilità pratica di interrogare il sistema per visualizzare pattern biologici su richiesta, per esempio quelli “intermedi” fra l’immagine risultante con un dato paziente e un’immagine di riferimento, e questo renderebbe più interpretabili le risposte del sistema. Figurativamente, possiamo pensare alle due singole immagini (quella ottenuta con la risonanza e quella di riferimento) come due punti su un mappamondo su cui siamo capaci di muoverci non solo esplorando le vicinanze di ogni località, col cambiamento progressivo di certe coordinate, ma anche collegando località distanti con un percorso di lunghezza minima.

Chiarito da un punto di vista matematico come misurare globalmente la distanza fra immagini e come connetterle due a due in modo ottimale, su questa specie di mappamondo, possiamo fare più facilmente due operazioni:

- separare regioni patologiche (popolate da immagini accomunate fra loro da una vicinanza “geografica” a certe immagini “capoluogo” individuate come critiche) da altre fisiologiche, con delle frontiere di separazione;

- generare immagini intermedie “critiche”, che si collocano cioè sulla frontiera di separazione, lungo il cammino che connette in modo ottimale un’immagine patologica a una fisiologica.

Come illustrato in Figura 2, questa idea è applicata per separare le risonanze in cui è prevista una variazione del numero di copie del gene (distinguendo fra casi con duplicazioni e cancellazioni) dalle risonanze classificate come fisiologiche. Grazie a questo set-up, poi, il sistema non solo acquisisce la capacità di classificare nuove immagini di risonanza, ricevute in seguito all’addestramento, ma permette all’utente di interagire attivamente, visualizzando in forma dinamica immagini in cui il pattern patologico sia presente, con delle animazioni che permettono di valicare progressivamente la separazione fra le immagini patologiche e quelle fisiologiche (o viceversa!).

Per questi motivi, il sistema proposto è qualcosa di diverso da un oracolo, rendendolo maggiormente capace di motivare le proprie risposte. Questa caratteristica è particolarmente apprezzabile per un sistema informatico nel contesto della medicina: nessuna diagnosi, nessun trattamento e nessuna terapia può dipendere dalle oscure operazioni di un’inestricabile scatola nera. A questo proposito riportiamo un aneddoto significativo. Durante una conferenza, ai partecipanti è stato chiesto di immaginare di doversi sottoporre a un intervento scegliendo fra un chirurgo umano (con una probabilità di morte del 15%) e una macchina (con una probabilità di morte del 2%), sapendo però di non poter comprendere il funzionamento del robot né di potergli rivolgere alcuna domanda su come operasse. Non sorprende che praticamente tutti abbiano espresso preferenza per il chirurgo umano, dimostrando una comprensibile diffidenza verso la cosiddetta intelligenza artificiale in situazioni critiche. L’opacità interpretativa non è solo quindi una questione epistemologica astratta, perché sul piano pratico ha l’implicazione di limitare la fiducia di medici e pazienti, ostacolando l’adozione di tecniche informatiche moderne. Questo è anche uno dei motivi per cui gli organismi dell’Unione Europea incoraggiano l’adozione di algoritmi progettati in modo tale che i risultati siano interpretabili dagli utenti.

Conclusioni

In conclusione, il team guidato da S. Kundu ha proposto di ingegnerizzare in modo automatico, ma interpretabile da un esperto medico, un test capace di ricercare nelle immagini di risonanze cerebrali tracce “invisibili a occhio nudo” della presenza di una variazione del numero di copie di un certo gene specifico, condizione genetica che altri studi correlano con la diagnosi di disturbi dello spettro autistico. La proposta di questa ricerca riguarda una tecnica denominata Transport Based Morphometry (TBM) perché implica l’uso di tecniche matematiche legate al trasporto ottimo, una teoria studiata in principio per tutt’altri motivi in tempi remoti e molto sviluppata in tempi relativamente recenti in vari campi, inclusa l’informatica, dimostrando un’ampia gamma di applicabilità. Del resto, lo stesso gruppo ha applicato le stesse idee anche alla diagnosi precoce di altre condizioni mediche, come la commozione cerebrale o l’osteoporosi. Con lo scopo finale di classificare le immagini delle risonanze rispetto alla presenza o meno dell’anomalia genetica correlata all’autismo, il trasporto ottimo entra in gioco nella TBM principalmente per formattare nel modo più opportuno i dati delle risonanze messi a disposizione degli algoritmi di apprendimento supervisionato (utilizzati per addestrare una rete neurale artificiale alla classificazione), in modo da favorirne quanto più possibile l’intepretabilità.

Giovanni Franzina

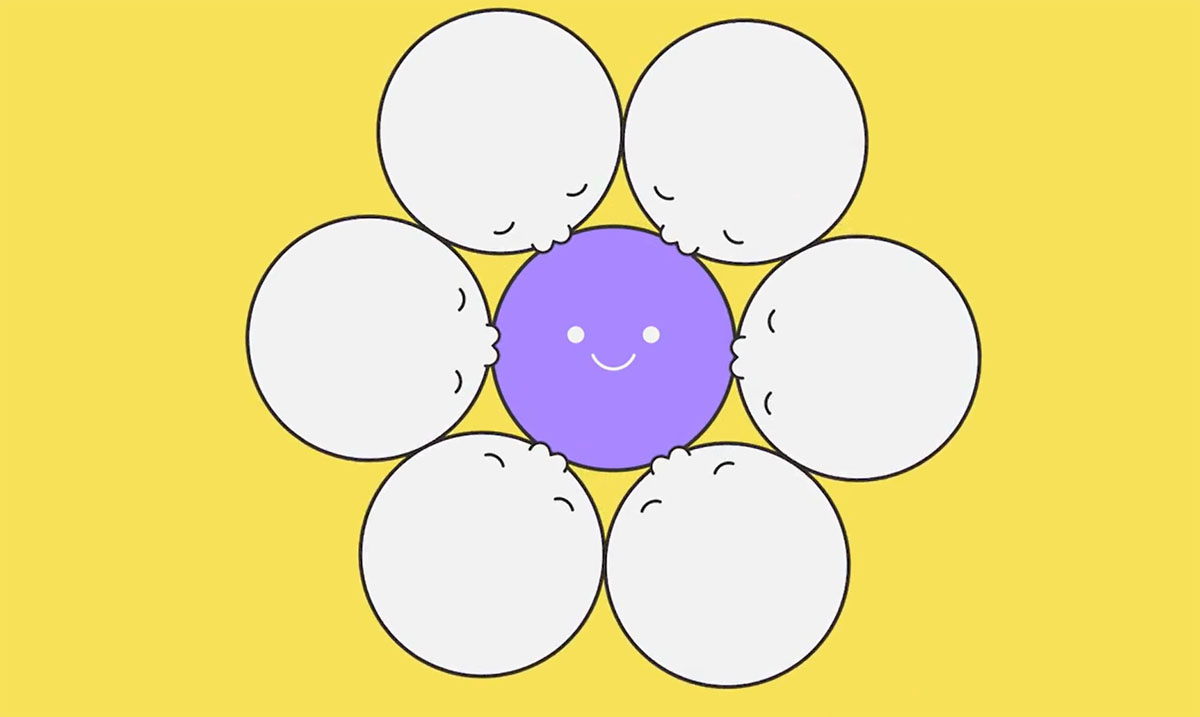

Immagine di copertina tratta dall’articolo S. Kundu & co

Apprezzo enormemente questo articolo per diversi motivi:

è molto chiaro nonostante la profondità dell’argomento;

svela (una volta di più…) che le applicazioni possono essere uno stimolo formidabile per lo sviluppo di teoremi;

abbatte il tabù dell’uso dell’apprendimento delle macchine;

sottolinea l’importanza che la matematica può avere nello sviluppo di “intelligenza artificiale” interpretabile.

Grazie!