Riuscirà l’IA a superare i limiti predittivi dei modelli matematici? Ne hanno scritto in un recente articolo Luca Gammaitoni e Angelo Vulpiani. Ce ne parla Marco Menale.

Prevedere il futuro è una delle sfide più affascinanti. Dal risultato di una partita di calcio alle elezioni, dalla meteorologia ai mercati finanziari, è il sogno nascosto dell’umanità. Tuttavia, tentativi e annunci si scontrano con varie difficoltà e complessità, con le conseguenze, poi, di previsioni non verificate. La modellistica fisico-matematica sta lavorando, da decenni, in questa direzione, con risultati alterni. L’avvento di big data e intelligenza artificiale sembra da una speranza di soluzione. Ma è proprio così? E fin dove possiamo spingerci?

Provano a rispondere Luca Gammaitoni e Angelo Vulpiani nell’articolo “Prediction and Inference: From Models and Data to Artificial Intelligence”. Luca Gammaitoni è un fisico e direttore del NiPS – Noise in Physical Systems Laboratory. Angelo Vulpiani è (oltre che anche lui un fisico, ma statistico) Professore di fisica teorica all’Università La Sapienza.

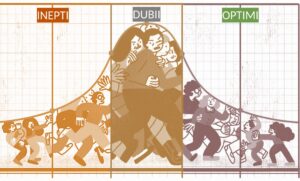

L’articolo parte dalle difficoltà che hanno i modelli matematici nel fare previsioni che siano sufficientemente corrette. Sono diverse le cause di queste difficoltà. Tra le altre, troviamo le dinamiche caotiche, che sono intrinseche al fenomeno in esame. Ancora, c’è la presenza di molteplici variabili con scale temporali caratteristiche molto diverse. Ma non è solo questione di matematica. C’è anche la mancanza di una conoscenza profonda e precisa della fisica che si nasconde dietro il fenomeno di interesse. Infatti, per quanto dettagliato possa essere il modello, mancherà sempre un tassello proprio perché manca una totale comprensione del fenomeno.

Gli autori mettono in luce come previsioni accurate richiedono una combinazione delicata di teoria e dati, sottolineando l’importanza crescente dell’intelligenza artificiale. Tuttavia, anche l’intelligenza artificiale ha i suoi limiti. Infatti, senza un solido quadro teorico che guidi la scelta delle variabili e l’interpretazione dei risultati, i sistemi di apprendimento automatico rischiano di trasformarsi in una sorta di “Biblioteca di Babele”. E in questo scenario, dati e correlazioni rischiano di sovrapporsi senza né ordine, né un significato preciso.

Come esempio c’è la meteorologia. Da un lato, grazie a modelli e dati dettagliati, possiamo fare previsioni a breve termine, sempre più precise anche grazie alla crescente potenza computazionale. Ma, dall’altro, il caos intrinseco del sistema atmosferico rende impossibile prevedere con certezza le condizioni a lungo termine. E non c’è IA che possa risolvere questi problemi. Gammaitoni e Vulpiani sottolineano come vecchi risultati, come il teorema di ricorrenza di Poincaré, il lemma di Kac e il paradosso di Richard confermino i limiti predittivi dei modelli matematici.

In definitiva, gli autori ci mettono in guardia rispetto alle capacità predittive dei modelli, che nascono principalmente per scopi descrittivi. E non saranno, almeno a ora, né i big data né l’IA a risolvere definitivamente il problema. Sotto questo punto di vista resta un certo ottimismo sul ruolo dell’essere umano nel processo modellistico e interpretativo dei fenomeni del mondo.