L’entropia ricorre spesso in matematica ed è entrata nel linguaggio quotidiano come sinonimo di disordine. Ci sono diverse definizioni in base al contesto. È il caso dell’entropia di Shannon in teoria dell’informazione. Ce ne parla Marco Menale.

Entropia è una delle parole che più alimentano l’immaginario fisico-matematico, al punto da entrare anche nel linguaggio quotidiano. Sentiamo dire “c’è troppa entropia” per descrivere una situazione di disordine. Originariamente introdotta in ambito termodinamico dal matematico e fisico tedesco Rudolf Clausius, l’entropia è tornata nel tempo anche in altri settori della matematica. Per questo motivo se ne trovano diverse definizioni. È il caso della teoria dell’informazione con l’entropia di Shannon.

La teoria dell’informazione ha l’obiettivo di fornire una descrizione quantitativa del concetto di informazione, oltre che studiare i fenomeni che avvengono sui canali di comunicazione. Il padre di questa teoria è l’ingegnere e matematico americano Claude Elwood Shannon, con l’articolo fondazionale del 1948 “A Mathematical Theory of Communication”. È in quest’articolo che Shannon introduce l’entropia nel senso della teoria dell’informazione: ecco perché si parla di entropia di Shannon.

Partiamo dalla definizione. Sia X=\{x1, \, x_2, \dots, x_n\} un insieme di n eventi, ciascuno con probabilità di verificarsi p_i. L’entropia H di questo sistema si definisce, a meno di una costante positiva di proporzionalità, come

H:=-\sum_{i=1}^n p_i \ln p_i,

dove la scelta del logaritmo soddisfa gli assiomi della teoria dell’informazione.

Per capirne il significato in termine di disordine (come ci aspettiamo) e il legame con il concetto di informazione facciamo un esempio.

Consideriamo una moneta con le sue due facce testa e croce. Ogni volta che si lancia la moneta c’è una probabilità p che esca testa e una probabilità 1-p che esca croce, con p \in [0,\, 1]. In particolare, per p=0.5 la moneta è equa. Dunque, l’entropia di Shannon dell’insieme dei due possibili esiti di un lancio è

H(p)=-p\ln p – (1-p)\ln(1-p).

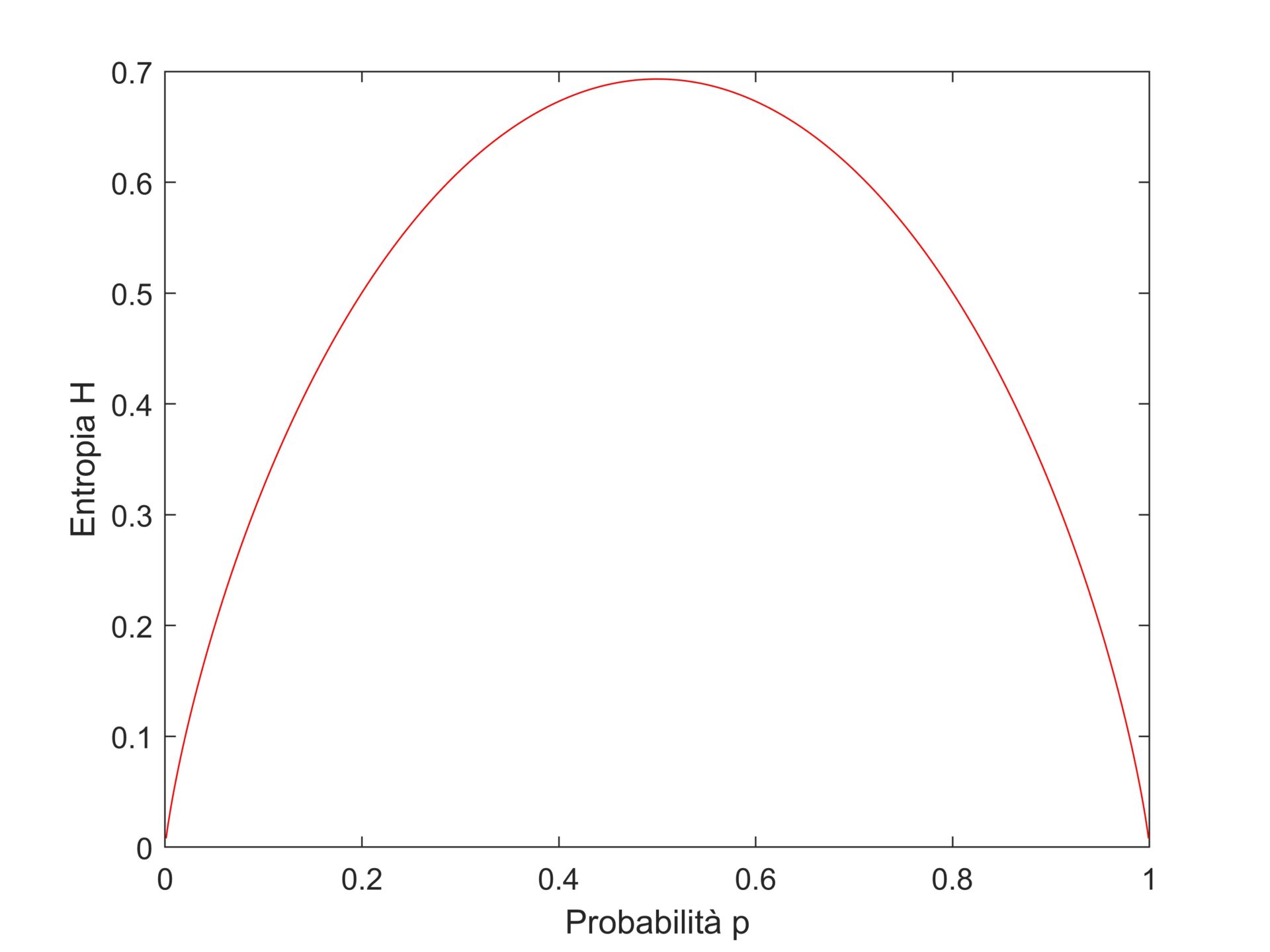

Semplici calcoli mostrano che questa funzione è nulla negli estremi, ossia per p=0,\, 1. Inoltre, derivandola rispetto a p si verifica che ha un punto stazionario (ossia H’(p)=0) per p=0.5, e questo punto è un massimo. Dunque, la funzione parte da 0 cresce fino a raggiungere il massimo in p=0.5 e, poi, decresce fino ad annullarsi in p=1 (Figura 1).

Figura 1. Grafico dell’entropia di Shannon H come funzione della probabilità p.

Rileggiamo questo comportamento in termini di informazione. Per p=0.5 abbiamo una moneta equa. In questo caso non abbiamo informazioni preliminari sul lancio della moneta, poiché c’è sempre un 50\% di probabilità che esca testa e un 50\% che esca, invece, croce. Ecco perché il sistema presenta entropia massima. Mentre, nei casi estremi l’entropia è minima. Ad esempio, il valore p=0 indica che a ogni lancio della moneta uscirà sicuramente croce (1-p=1), quindi abbiamo il massimo dell’informazione dal sistema ed ecco perché è minima l’entropia; non ci sarà nessuna sorpresa in un lancio. In definitiva, l’entropia di Shannon fornisce una misura di quanta informazione c’è in un insieme di eventi. Meno ce n’è più alto è il valore dell’entropia, e viceversa. Ed è coerente con quanto ci aspettiamo dalla definizione termodinamica. Infatti, se c’è molta entropia di Shannon, la mancanza di informazioni traduce il concetto di disordine.

Nel senso più stretto della teoria dell’informazione, l’entropia di Shannon misura la quantità di informazione di un messaggio scambiato attraverso un canele di telecomunicazione. Se ne possono anche fornire definizioni diverse, ad esempio nel caso di un insieme continuo di eventi, con applicazioni, tra le altre, alla misura delle disuguaglianze.