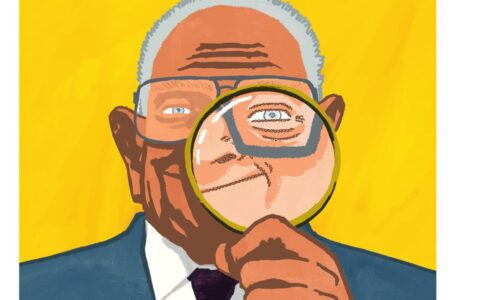

Il 5 luglio scorso, come ormai è (buona) consuetudine, INVALSI ha presentato presso il MIUR il rapporto sui risultati nelle prove degli studenti italiani. Quest’anno Pietro Di Martino non ha potuto partecipare (come lo scorso anno, vedi commento) e dunque ci propone questo commento in base ai documenti che INVALSI mette a disposizione sul proprio sito qui.

di Pietro Di Martino

La presentazione ufficiale dei risultati e la produzione dei documenti a cui faccio riferimento è sicuramente una buona prassi; tra l’altro molto apprezzabile è lo sforzo dell’Istituto di uscire in tempi brevi e certi: sull’home page dell’INVALSI è presente la calendarizzazione dell’uscita pubblica dei documenti di accompagnamento. La produzione di questi documenti è fondamentale perché, al netto della sempre maggior rilevanza ed eco che i risultati delle prove INVALSI hanno, presenta al pubblico un punto di vista esplicito e dunque criticabile, nel senso che dà la possibilità a chiunque di sviluppare un’analisi critica dello stesso.

Di seguito offro la mia personale analisi soffermandomi in particolare sugli aspetti che ritengo maggiormente delicati dei documenti prodotti. Il rapporto si occupa di commentare i risultati nelle prove, quindi – se non lateralmente – non commenterò il tipo di problemi usati nel 2017/18. Sottolineo solo che, secondo me, si conferma un lavoro importante a tutti i livelli scolari nella costruzione delle prove stesse: le prove di Matematica, al di là delle modalità tipiche delle rilevazioni standardizzate, sono molto migliorate e spesso composte da problemi non banali che mettono in gioco aspetti significativi dell’educazione matematica.

L’introduzione delle CBT

Uno degli aspetti maggiormente evidenziati nel Rapporto e nelle varie presentazioni – una delle novità per l’a.s. 2017/18 – è l’introduzione delle Computer Based Test (CBT), ovvero delle prove svolte al computer per i livelli 8 e 10. Questa novità da una parte ha ridotto il carico di lavoro relativo alle prove dei docenti coinvolti (la correzione è centralizzata), dall’altra ha sicuramente diversi vantaggi per gli obiettivi di rilevazione dell’istituto:

- aumento della partecipazione alle prove;

- diminuzione del fenomeno del cheating. Su questo un commento al volo, non sono convinto della “valenza etica ed educativa di questo importante cambiamento” sottolineata nel Rapporto: ritengo che non sia tale una riduzione dovuta a “diminuizione delle opportunità” (è più difficile produrre il cheating);

- possibilità di fare studi longitudinali sui risultati ad uno stesso quesito: ovvero si vorrà forse confrontare i risultati su uno stesso quesito riproposto in anni diversi.

Quest’ultimo aspetto, molto interessante anche per i ricercatori, può però limitare una delle caratteristiche essenziali delle prove: quella di essere pubbliche e quindi permettere una riflessione più approfondita in aula sulle stesse e sui processi attivati per rispondere. La speranza è che INVALSI non sacrifichi al CBT il fondamentale archivio di prove che differenziava in positivo la rilevazione INVALSI da quelle PISA e TIMSS. Le rilevazioni internazionali rilasciano solo poche prove campione, avendo come unico interesse quello rilevativo e non quello di confronto diretto con il mondo educativo.

Per chiudere il discorso sulle prove CBT, giustamente la presentazione del Rapporto vuole sottolineare lo sforzo e i risultati dell’istituto nell’implementazione di questa modalità. Non mettendo in discussione il grosso lavoro fatto, la percentuale bassa di segnalazioni di difficoltà di erogazione della prova non deve però offuscare le molte difficoltà e forti preoccupazioni mute (non segnalate) delle scuole. L’impressione è che uno dei meriti involontari dell’introduzione delle prove CBT sia stato quello di evidenziare le necessità informatiche di molte scuole (che hanno problemi di disponibilità di posizioni, di mancanza di tecnici, di rete non proprio veloce). Sarebbe bene che queste difficoltà mute (forse anche per paura di fare brutta figura) trovassero voce e trovassero chi di dovere pronto ad intervenire. Gli altri due punti che voglio commentare sono legati a due aspetti importanti e, a mio avviso, particolarmente delicati: la restituzione dei risultati (in particolare l’interpretazione dei dati quantitativi) e l’introduzione dei livelli di competenza.

I livelli di competenza

Per quanto riguarda la novità dei livelli di competenza – che, come ricordato nel Rapporto, in base al Decreto legislativo n. 62/2017 sono riportati sul documento di “Certificazione delle competenze al termine del primo ciclo d’istruzione” rilasciato agli allievi che escono dalla scuola secondaria di primo grado e che in qualche modo avvicinano INVALSI alle prassi delle rilevazioni PISA e TIMSS – le mie perplessità personali sono su diversi piani: di metodo, di merito e di opportunità.cLa storia per quanto riguarda il livello 8 (la terza “media”) è abbastanza nota: la prova INVALSI era inserita nell’Esame di Stato al termine del primo ciclo d’istruzione. Questa presenza ha da sempre destato diverse perplessità ed è stato alla fine deciso di togliere la prova dall’Esame conclusivo, ma lasciarla comunque obbligatoria, con una valutazione autonoma. Questa valutazione comprende la descrizione di livelli di competenza. Se qualche perplessità rimane sul fatto che una rilevazione che nasce per certi obiettivi (valutazione di sistema) sia usata anche per obiettivi differenti (valutazione di singoli), ritengo che la presenza anche di una valutazione esterna in uscita da un ciclo d’istruzione possa essere significativa e non sia di per sé sbagliata.

L’aspetto che lascia più perplessi è però proprio l’aspetto descrittivo che si pretende da questa valutazione esterna. I livelli di competenza sono infatti presentati come uno strumento descrittivo per insegnanti, dirigenti e studenti: l’esito delle prove produce un resoconto non solo quantitativo, ma anche qualitativo. Questo intento descrittivo però stride profondamente con il fatto che la definizione, lo sviluppo e soprattutto l’identificazione di questi livelli non è a mio avviso criticabile, nel senso che ho introdotto all’inizio. L’impressione è che alla fine il lettore debba fidarsi della bontà delle scelte degli esperti senza realmente poterle controllare e, vista la delicatezza e la rilevanza del messaggio che si vuole condividere e di ciò che si vuole certificare, questa è una criticità assoluta. Il Rapporto di per sé infatti non fornisce sufficienti informazioni su come i livelli siano stati costruiti e rimanda ad una documentazione più specifica. Questa documentazione fornisce esempi di domande per ciascun livello di competenza – e già entrando nel merito di questo si potrebbero obiettare diverse scelte (rientrando però nell’alveo di quel che ho definito criticabile) – ma non dice molte cose (o io non le ho capite): ad esempio come si integrano le risposte ai diversi quesiti per creare il livello finale (si fa riferimento e si usano ovviamente strumenti statistici, per i quali appunto il lettore può solo verificare il risultato finale) e quali serie di risposte diverse producono lo stesso livello di competenza.

A parte la convinzione che la documentazione prodotta non spieghi davvero le scelte che determinano il risultato finale, il problema principale è quello degli obiettivi e delle possibilità di una rilevazione standardizzata. Personalmente non so se descrivere i livelli di competenza qualitativi del singolo vada oltre gli obiettivi di una rilevazione standardizzata (mi rispondo da solo: evidentemente no perché le è richiesto di farlo), ma rimango fermamente convinto che vada oltre le possibilità di una rilevazione standardizzata. Questa posizione si basa su due mie convinzioni specifiche molto nette: da una parte una prova standardizzata non ha strumenti per valutare qualitativamente i processi di pensiero attivati per rispondere ad una domanda – tali processi non possano essere inferiti in maniera deterministica né solo in base al problema in gioco (a priori), né in base a modelli statistici che analizzano l’insieme delle risposte date – dall’altra nessuna prova, che sia di realtà, a risposta aperta o specificatamente strutturata, può da sola permettere di stabilire il grado di competenza di un singolo. Insomma, una cosa è certificare che la performance di un allievo in una valutazione esterna conclusiva (che intende valutare determinati aspetti) è stata di un certo tipo, considerando anche le note influenze emozionali di fronte ad una prova esterna e finale. Un’altra è appunto pretendere di poter descrivere i livelli di cosa sa fare (e sotto sotto, che se ne dica, anche suggerire cosa non sa fare) l’allievo dall’esito di tale prova. Questa tensione irrisolta tra legittima valutazione di una performance e molto più criticabile descrizione dei livelli di competenza dell’allievo emerge anche nel Rapporto INVALSI, dove in più parti si scrive: “Posto il livello 3 come livello di sufficienza”.

La restituzione dei risultati e l’equità del sistema educativo

Chiudo commentando la parte del Rapporto d’interpretazione dei dati quantitativi: i dati INVALSI, a mio avviso, sono molto preziosi per descrivere macro-fenomeni significativi, su cui la comunità educativa dovrebbe comunque interrogarsi. Tipicamente, come in tutte le rilevazioni quantitative, i macro-fenomeni più evidenziati sono quelli relativi a differenze di punteggio macroscopiche: tra macro-aree geografiche, tra scuole, tra classi, tra allievi in base a genere, condizione socio-economiche o altre caratteristiche. Anche il Rapporto di quest’anno evidenzia fenomeni significativi e talvolta preoccupanti legati alle differenze quantitative: ad esempio il fatto che ci siano forti differenze tra macro-aree nei punteggi in matematica. Emergono anche dati longitudinali interessantissimi: ad esempio rispetto alle differenze di cui sopra, il fatto che siano praticamente assenti all’inizio della scuola primaria.

Questi fenomeni ripeto, a mio avviso, dovrebbero essere presi in considerazione dal sistema educativo, studiati a fondo andando al di là dell’aspetto meramente quantitativo, ed infine interpretati. Il dato quantitativo permette di evidenziare alcuni fenomeni (che si possono ritenere più o meno significativi), ma va maneggiato con estrema cautela.

Al netto dei dati numerici, a me pare evidente che l’interpretazione di fenomeni complessi richieda da una parte molta cautela, dall’altra una chiarezza assoluta sia sulla definizione del fenomeno stesso (spesso appunto a rischio di essere inteso in maniera differente da persone differenti) che sugli assunti di partenza che guidano l’interpretazione. In questo, da tempo ritengo che i Rapporto INVALSI dovrebbero da una parte essere più cauti nell’offrire la legittima interpretazione degli esperti dell’istituto, evitando di suggerire – anche attraverso il linguaggio usato (ciò significa, quindi, di conseguenza, implica) – inferenze deterministiche dai dati quantitativi. Dall’altra, esplicitare in maniera più chiara possibile gli assunti di partenza, il punto di vista adottato, riducendo i margini di ambiguità, soprattutto quando si commentano e trattano aspetti particolarmente delicati. Un concetto cruciale – ricorrente nel commento di differenze quantitative significative e al quale il Rapporto INVALSI dedica un apposito paragrafo “Quanto è equa la scuola” – è quello di equità del sistema educativo. Il Rapporto INVALSI propone la seguente definizione di equità:

Lo stesso Rapporto stabilisce un indicatore specifico di non equità:

Personalmente, senza scomodare citazioni evangeliche e storie di talenti, non sono per niente convinto che la qualità di offerta educativa (su cui si basa il giudizio di equità) possa essere ridotta ai risultati assoluti in una prova (standardizzata) degli studenti. Rimane poi l’aspetto dell’ambiguità che a me pare non risolto nella definizione di equità del sistema educativo proposta: cosa si intende per eguaglianza di trattamento? E per stesse condizioni?

Si può certamente obiettare che non è possibile esplicitare tutto. Ne sono pienamente consapevole e sono certamente d’accordo, ma rigiro la questione: alcuni termini, alcune espressioni non si possono usare senza chiarirne il significato. La risposta alle domande precedenti è infatti cruciale per capire l’interpretazione proposta dal Rapporto INVALSI, per discuterla e, dunque, per permettere di prendere posizione consapevolmente. Tra l’altro, la risposta (implicita) che sembra emergere proseguendo la lettura del paragrafo INVALSI mi lascia veramente molto perplesso (rimane il dubbio interpretativo, ma come accennato sopra questo è un problema di per sé). Leggiamo insieme il paragrafo in questione:

Anche in questo pezzo c’è un termine cruciale che rimane indefinito (progresso di un alunno) e un approccio deterministico (questo implica), a mio modo di vedere molto discutibile. Non sono infatti per niente convinto che l’esistenza dell’influenza di contesto (fenomeno effettivamente rilevato dalla ricerca educativa) implichi che il progresso di un alunno sarà minore se il livello medio del gruppo è basso e omogeneo (ritengo che probabilmente anche Don Milani avrebbe qualcosa da obiettare relativamente a questa implicazione…).

Ma ciò che mi lascia più perplesso del pezzo analizzato è proprio l’idea di equità del sistema educativo che sembra emergere. Infatti, quelli che sono presentati come effetti indiretti dell’effetto di contesto, e che implicitamente (forse mi sbaglio, spero di sbagliarmi, ma si torna al discorso di cui sopra) sembrano essere presentati come effetti indesiderati negativi, a me appaiono aspetti essenziali di un’educazione che mette al centro la persona, come d’altra parte richiesto dalle nostre Indicazioni Nazionali per il primo ciclo:

Una scuola di base che offre lo stesso progetto educativo, le stesse azioni agli allievi indipendentemente dai loro bisogni, e anche che li valuta non valorizzando i loro talenti (come richiesto sempre dalle Indicazioni Nazionali), ma utilizzando solo strumenti misurativi definiti a priori e che prescindono dalla persona, nella mia visione non è una scuola equa, non è la scuola che vorrei.

Nella mia mente la scuola equa è proprio quella che dà la stessa importanza e che si fa carico con la stessa energia delle necessità educative differenti dei diversi allievi. È una scuola più complessa e difficile per i diversi attori in gioco della scuola che stabilisce buone pratiche a prescindere dal contesto: mette in gioco la professionalità di insegnanti (e anche dirigenti che devono favorire questo processo) perché impedisce di volare con il pilota automatico, costringe (ma in questo caso secondo me è una costrizione bella) a mettersi sempre in gioco, a rinnovarsi e, a mio avviso, responsabilizza maggiormente anche gli allievi stessi.

Ritengo che INVALSI abbia le potenzialità per dare un contributo in questo senso, in termini di: strumenti di osservazione (una valutazione esterna in momenti ben determinati e distanziati negli anni offre elementi di riflessione cruciali per uscire dall’autoreferenzialità), sviluppo di problemi significativi e legati con obiettivi di apprendimento, offerta di dati quantitativi (e analisi offerte nei Rapporto) che possono evidenziare difficoltà diffuse o stanare difficoltà silenti. Ma è evidente che per dare questo contributo a monte ci deve essere una vera e propria scelta di campo: la qualità (ed equità) dell’offerta educativa di base dipende fortemente dalla capacità di considerare le necessità di chi si ha di fronte, dunque, al netto degli obiettivi di lungo periodo fissati dalle Indicazioni Nazionali, la differenziazione dei percorsi (e anche dei metodi di valutazione) nelle singole esperienze educative è un valore fondamentale, non un effetto indiretto indesiderato.

Pietro Di Martino

Sono importantissime le questioni poste da Pietro Di Martino in questo suo articolo.

Richiamo solo alcuni passi che ritengo cruciali.

Punto 1: rispetto al “fidarsi”

“[…] L’aspetto che lascia più perplessi è però proprio l’aspetto descrittivo che si pretende da questa valutazione esterna. I livelli di competenza sono infatti presentati come uno strumento descrittivo per insegnanti, dirigenti e studenti: l’esito delle prove produce un resoconto non solo quantitativo, ma anche qualitativo. Questo intento descrittivo però stride profondamente con il fatto che la definizione, lo sviluppo e soprattutto l’identificazione di questi livelli non è a mio avviso criticabile, nel senso che ho introdotto all’inizio. L’impressione è che alla fine il lettore debba fidarsi della bontà delle scelte degli esperti senza realmente poterle controllare e, vista la delicatezza e la rilevanza del messaggio che si vuole condividere e di ciò che si vuole certificare, questa è una criticità assoluta. Il Rapporto di per sé infatti non fornisce sufficienti informazioni su come i livelli siano stati costruiti e rimanda ad una documentazione più specifica. Questa documentazione fornisce esempi di domande per ciascun livello di competenza […], ma non dice molte cose (o io non le ho capite): ad esempio come si integrano le risposte ai diversi quesiti per creare il livello finale (si fa riferimento e si usano ovviamente strumenti statistici, per i quali appunto il lettore può solo verificare il risultato finale) e quali serie di risposte diverse producono lo stesso livello di competenza. e, vista la delicatezza e la rilevanza del messaggio che si vuole condividere e di ciò che si vuole certificare, questa è una criticità assoluta. […].

Punto 2 (rispetto a definizioni e assunti di partenza)

[…] Al netto dei dati numerici, a me pare evidente che l’interpretazione di fenomeni complessi richieda da una parte molta cautela, dall’altra una chiarezza assoluta sia sulla definizione del fenomeno stesso (spesso appunto a rischio di essere inteso in maniera differente da persone differenti) che sugli assunti di partenza che guidano l’interpretazione. In questo, da tempo ritengo che i Rapporto INVALSI dovrebbero da una parte essere più cauti nell’offrire la legittima interpretazione degli esperti dell’istituto, evitando di suggerire – anche attraverso il linguaggio usato (ciò significa, quindi, di conseguenza, implica) – inferenze deterministiche dai dati quantitativi. Dall’altra, esplicitare in maniera più chiara possibile gli assunti di partenza, il punto di vista adottato, riducendo i margini di ambiguità, soprattutto quando si commentano e trattano aspetti particolarmente delicati […].

Punto 3 (rispetto ai significati attribuiti ad alcuni termini)

[…] Si può certamente obiettare che non è possibile esplicitare tutto. Ne sono pienamente consapevole e sono certamente d’accordo, ma rigiro la questione: alcuni termini, alcune espressioni non si possono usare senza chiarirne il significato. La risposta alle domande precedenti è infatti cruciale per capire l’interpretazione proposta dal Rapporto INVALSI, per discuterla e, dunque, per permettere di prendere posizione consapevolmente. Tra l’altro, la risposta (implicita) che sembra emergere proseguendo la lettura del paragrafo INVALSI mi lascia veramente molto perplesso (rimane il dubbio interpretativo, ma come accennato sopra questo è un problema di per sé).[…].

Le questioni sopracitate, e molte altre che l’articolo di Di Martino mettono in campo, sono aspetti cruciali e richiedono pareri, valutazioni e, soprattutto, risposte, proprio per evitare il rischio di fideismo o che prendano piede certe vaghezze terminologiche, inconciliabili con un reale spirito scientifico, rispetto ad un tema delicatissimo quale è quello della valutazione.